INDUCCION 2016

ARQUITECTURA 1

GUIA ARQUITECTURA 1

ACTIVIDADES

ACTIVIDAD N° 1 (LECTURA ORIGEN Y COMPONENTES DE LOS PC)

ACTIVIDAD N° 2 (HISTORIA DEL COMPUTADOR MARAVILLAS MODERNAS)

ACTIVIDAD N° 3 (LA PLACA BASE)

ACTIVIDAD N° 4 (EL MICROPROCESADOR)

UNIDAD N° 1: FUNDAMENTOS DE ARQUITECTURA COMPUTACIONAL

1.ARQUITECTURA DE ORDENADORES

1.1. CONCEPTO DE ARQUITECTURA EN EL ENTORNO INFORMÁTICO Lo que se denomina hardware de computadores consiste en circuitos electrónicos, visualizadores, medios de almacenamiento magnéticos y ópticos, equipos electromecánicos y dispositivos de comunicación. Por lo que la arquitectura de computadoras abarca la especificación del repertorio de instrucciones y las unidades hardware que implementan las instrucciones.

1.2. DEFINICIÓN DE COMPUTADORA Un computador o computadora es una máquina calculadora electrónica rápida que acepta como entrada información digitalizada, la procesa de acuerdo con una lista de instrucciones almacenada internamente y produce la información de salida resultante. A la lista de instrucciones se le conoce como programa y el medio de almacenamiento interno memoria del computador. Hay muchos tipos de computadores, varían en tamaño, costo, poder de cómputo y uso.

El computador personal es el más común, el cual encuentra amplia aplicación en hogares, centros de enseñanza y oficinas de negocios. Se encuentra conformado por unidades de procesamiento y de almacenamiento, unidades de salida de visualización y de salida de audio, así como de un teclado, lo que permite su fácil ubicación sobre una mesa en el hogar o en la oficina. Los medios de almacenamiento incluyen discos duros, CD-ROM y disquetes.

Los computadores portátiles son la versión compacta con todos los componentes empaquetados. Las estaciones de trabajo con capacidad de entrada/salida de gráficos de alta resolución, aunque con las dimensiones de un computador de sobremesa, se caracterizan por su rapidez de procesamiento; se usan frecuentemente en aplicaciones de ingeniería, especialmente para trabajo de diseño interactivo.

Asimismo, se encuentran los sistemas de empresa o macrocomputadores, los cuales son ocupados para el procesamiento de datos de negocios en compañías de tamaño mediano a grande que requieren bastante poder de computación y capacidad de almacenamiento que la ofrecida por las estaciones de trabajo.

Los servidores (son una computadora que, formando parte de una red, provee servicios a otras computadoras denominadas clientes), contienen unidades de almacenamiento para bases de datos de tamaño mediano, y son capaces de gestionar un gran volumen de peticiones de acceso a esos datos. En la mayoría de los casos los servidores son accesibles a las comunidades educativas, empresariales y particulares. Las peticiones y las respuestas se transportan habitualmente a través de las instalaciones de internet. Internet y sus servidores asociados se han convertido en la fuente dominante mundial de toda clase de información. Las instalaciones de comunicación de internet consisten en una compleja estructura de enlaces principales de fibra óptica de alta velocidad interconectados con cable de difusión y conexiones telefónicas a escuelas, negocios y hogares. Por otro lado, están los supercomputadores que se utilizan para cálculos numéricos a gran escala y requeridos en aplicaciones como predicción del tiempo o diseño y simulación de aeronaves. En sistemas empresariales, servidores y supercomputadores, las unidades funcionales, incluyendo múltiples procesadores, pueden consistir en varias unidades separadas y frecuentemente grandes

1.3 ORGANIZACIÓN FÍSICA DE UNA COMPUTADORA

1.3.1 Dispositivos de entrada Norton Peter en su libro Introducción a la computación señala que “a principios de la década de 1980, cuando las computadoras personales comenzaron a ganar popularidad, muchos futuristas y analistas hicieron predicciones audaces acerca de la importancia de la computadora para la sociedad. Algunas personas incluso predijeron que, para el año 2000, en ningún hogar faltaría una computadora”. La computadora se conforma por dos elementos principales: hardware y software. El hardware se refiere a la parte física de la computadora: teclado, gabinete, circuitos, cables, discos duros, impresoras, monitores, etc. El funcionamiento del hardware depende del software (programas).3 En tanto que software, Villarreal 4 lo define como el conjunto de instrucciones que dirigen al hardware. Asimismo, dice que es un conjunto de instrucciones que realizan una tarea específica denominada programa. El dispositivo de entrada se define como la parte del hardware que permite al usuario introducir información a la computadora. Por ejemplo: teclado, ratón, lector óptico, escáner, guantes (para realidad virtual), cámaras digitales de video, etc

El dispositivo de entrada más común es el teclado, el cual acepta letras, números y comandos del usuario. Además, en forma adicional se emplea el ratón, el cual permite dar comandos moviendo el ratón sobre una superficie plana y oprimiendo sus botones. Algunos otros dispositivos de entrada son la palanca de juegos (joystick), escáner, cámaras digitales y micrófonos. 1.3.2 Dispositivos de salida Es la parte que permite a la computadora comunicarse con el usuario. Ejemplos: monitor, graficador, bocinas, impresora, etc. Ejemplo de monitor. www.ordenadores-y-portatiles.com Ejemplo de graficador. www.ordenadores-y-portatiles.com Ejemplo de impresora. www.computacion-insumos.com.ar Los dispositivos de salida devuelven los datos procesados al usuario. El término genérico dispositivo se refiere a cualquier pieza de hardware. La función de un dispositivo de salida es presentar datos procesados al usuario. Los dispositivos de salida más comunes son la pantalla de visualización, conocida como monitor y la impresora.5 Existen algunos tipos de hardware que pueden actuar tanto como dispositivos de entrada como de salida. Un ejemplo es la pantalla sensible al tacto, un tipo e monitor que muestra texto o íconos, los cuales pueden tocarse

Las pantallas sensibles al tacto permiten a los usuarios localizar con rapidez artículos o buscar en catálogos. Los tipos más comunes de dispositivos que pueden ser de entrada y salida son los de comunicación, los cuales conectan una computadora con otra, proceso conocido como conectividad en redes. Entre las muchas clases de dispositivos de comunicación, los más comunes son los módems, los cuales permiten a las computadoras comunicarse a través de líneas telefónicas, y las tarjetas de interfaz de red (network interface cards; NIC), las cuales permiten a los usuarios conectar un grupo de computadoras para compartir datos y dispositivos.6 1.3.3 Memoria interna y memoria externa La computadora, para ser realmente útil, necesita un lugar para mantener archivos de programas y datos relacionados cuando no se están usando. El propósito del almacenamiento es guardar datos. Existen diferencias entre el almacenamiento y la memoria. Los contenidos son conservados en el almacenamiento cuando la computadora se apaga, mientras que los programas o datos que se ponen en la memoria se pierden cuando se apaga la computadora. El medio de almacenamiento más común es el disco magnético. Un disco es un objeto plano redondo que gira alrededor de su centro. Conformado por cabezas de lectura/escritura, semejantes a las cabezas de una grabadora de cintas o de una videograbadora. El dispositivo que contiene a un disco se le llama unidad de disco. Algunos discos están construidos dentro de la unidad y no están hechos para ser removidos. La mayoría de las computadoras personales contienen un disco duro no removible. Las unidades de CDROM, unidades de cinta, unidades ópticas unidades de disco duro removibles constituyen otros tipos de dispositivos de almacenamiento. El tipo empleado en las computadoras se denomina disco compacto de sólo lectura (Compact Disk Read-Only Memory: CD-ROM), el nombre implica que no se puede cambiar la información en el disco, del mismo modo que no se puede grabar sobre un CD de audio. Otra tecnología de almacenamiento de datos que está surgiendo es el disco digital versátil (digital versatile disk; DVD) puede almacenar una película entera de largo metraje. Los disco DVD requieren un reproductor especial; sin embargo, los reproductores nuevos por lo general pueden reproducir discos de sonido, datos y DVD, por lo que el usuario ya no debe comprar reproductores diferentes para cada tipo de disco.7 La memoria principal almacena datos y programas temporalmente. En estos circuitos deben encontrarse los programas y los datos (en código binario), para ser ejecutados por el procesador. Los programas y datos almacenados en el disco tienen que ser cargados a memoria antes de ser ejecutados por el microprocesador. La memoria secundaria es utilizada para almacenar datos indefinidamente, ejemplos: disquetes, discos duros, unidades extraíbles. Aquí se almacenan los archivos de los usuarios, además de los programas.

1.4 GENERACIONES DE COMPUTADORAS Villarreal expresa que las tecnologías de la información de los últimos 50 años se han dividido en cuatro etapas o generaciones de computadoras. Señala que la división por computadoras se debe a la tecnología utilizada para crear el elemento lógico principal, y lo describe como el componente electrónico utilizado para almacenar y procesar la información, utilizando en las computadoras durante cada periodo.

1.5 TIPOS DE GENERACIONES

Primera generación (1951-1958). Describe que se inicia cuando la oficina de censos de Estados Unidos utilizó la UNIVAC 1 en 1951. Estas primeras computadoras estaban fabricadas con bulbos (tubos de vidrio del tamaño de un foco, que contienen circuitos eléctricos). Cabe destacar que la Universal Automatic Computer (UNIVAC 1) fue desarrollada por Mauchly y Eckert para la Remington-Rand Corporation; fue expuesta a nivel nacional cuando pronosticó de manera correcta la victoria de Dwight Eisenhower sobre Adlai Stevenson en las elecciones presidenciales estadounidenses con sólo 5% de los votos contados. En la primera generación, el medio para introducir información eran las tarjetas perforadas —describe Villarreal—, y utilizaban tambores magnéticos para almacenamiento de datos externo. Los programas eran escritos en lenguaje máquina (instrucciones escritas como cadenas de ceros y unos) o en lenguaje ensamblador, el cual permite al programador escribir instrucciones en palabras abreviadas, y luego traducirlas por otro programa (llamado ensamblador) al lenguaje máquina. Señala que estas máquinas se colocaban en centros de cómputo con clima controlado y personal técnico para programarlo y mantenerlo en operación. Eran muy grandes, costosas, consumían mucha electricidad y producían bastante calor. Por lo mismo, pocas instituciones podían invertir en una computadora así. A pesar de esas deficiencias —expone Villareal—, los computadores de la primera generación rápidamente se convirtieron en herramientas indispensables para los científicos, ingenieros y para las aplicaciones comerciales grandes, como nómina y facturación. Las telecomunicaciones en esa época se llevaban a cabo por teléfono y teletipo a una velocidad muy baja

Segunda Generación (1959-1963). Estas computadoras —señala Villareal—, se caracterizan por estar constituidas con transistores en lugar de bulbos. Asimismo, los transistores se emplearon por primera vez en una computadora en 1956, y podían desempeñar la misma función que un bulbo, pero ocupaban mucho menor espacio y eran más confiables. No utilizaban tanta energía ni producían mucho calor; además, eran rápidas y poderosas. Pero los transistores tenían que ser alambrados manualmente y soldados unos a otros para formar circuitos. En esta época los tambores magnéticos son reemplazados por núcleos magnéticos como medio de almacenamiento primario. Las cintas magnéticas y el disco como medio de almacenamiento secundario, sustituyeron a las tarjetas perforadas; proporcionaban mayor capacidad de compresión de datos y eran más rápidos. Se desarrollaron las telecomunicaciones entre las computadoras. En esta época se desarrollaron lenguajes de programación de alto nivel, es decir, las instrucciones de los programas podían escribirse en palabras parecidas al lenguaje humano y en expresiones matemáticas; por ejemplo, FORTRAN y COBOL, estos lenguajes permitieron que las computadoras fueran más accesibles para los científicos y los negocios.

Tercera Generación (1964-1979). En esta generación las computadoras basadas en transistores son sustituidas por máquinas más pequeñas y poderosas, construidas con circuitos integrados; los cuales contenían miles de pequeños transistores en un chip de silicio. Los chips ahorraban espacio, expresa Villarreal, no requerían alambrado ni soldadura manual, y eran más confiables y rápidos que los transistores. Se desarrolló una nueva memoria, MOS (semiconductor de óxido metálico) al igual que los circuitos integrados, éstas utilizaban chips cubiertos con silicón. A causa del incremento en la capacidad de memoria y poder de procesamiento, hizo posible el desarrollo de sistemas operativos. Surgieron también las minicomputadoras. Se desarrollaron lenguajes de programación como BASIC. El primer satélite de comunicaciones fue lanzado, conduciendo a

Cuarta Generación. Se caracteriza por la introducción de circuitos integrados a gran escala (LSIC) y circuitos integrados a una mayor escala (VLSIC), y por los microprocesadores. Estos circuitos integrados contienen desde cientos de miles hasta más de un millón de transistores en un pequeño chip. Los microprocesadores contienen, memoria, lógica y circuitos de control (un procesador completo) en un pequeño chip de silicio. En esta época la memoria de semiconductores se incrementó a la par que su velocidad, mientras su precio descendía. Se introdujeron las computadoras personales Apple e IBM, y se hicieron populares en los negocios y en el hogar. Los lenguajes de cuarta generación como Dbase, Lotus 1-2-3, y WordPerect tenían ya listo su mercado. En esta generación se desarrolló la telecomputación, siendo internet el primer ejemplo Hoy en día, el tipo más común de computadora se llama computadora personal, o PC, porque está diseñada para ser usada por una sola persona a la vez. A pesar de su tamaño pequeño, la computadora personal moderna es más potente que cualquiera de las máquinas del tamaño de un cuarto de las décadas de 1950 o 1960. Mucha gente de negocios usa una computadora aún cuando está fuera de oficina. Por ejemplo, la mayoría de los que viajan ahora llevan computadoras portátiles, conocidas como computadoras laptop o computadoras notebook, las cuales pueden ser tan potentes como los modelos de escritorio. Villarreal señala que en la actualidad se encuentran las computadoras de propósito específico y de propósito general. Especifica que no todas las computadoras son de propósito general, es decir, que se pueden programar para efectuar distintas aplicaciones. También existen computadoras de propósito especial (dedicadas) que llevan a cabo tareas específicas, desde controlar la temperatura y la humedad en un edificio de oficinas, hasta supervisar el ritmo cardiaco de una persona mientras hace ejercicio. Las computadoras de propósito específico se incorporan en todo tipo de bienes de consumo: relojes de pulso, máquinas de juego, aparatos de sonido, grabadoras de video, hornos de microondas y hasta automóviles. Estas computadoras también son ampliamente utilizadas en la industria, la milicia, y la ciencia, donde controlan todo tipo de dispositivos, incluso robots

Quinta Generación (1983 al presente)

En vista de la acelerada marcha de la microelectrónica, la sociedad industrial se ha dado a la tarea de poner también a esa altura el desarrollo del software y los sistemas con que se manejan las computadoras. Surge la competencia internacional por el dominio del mercado de la computación, en la que se perfilan dos líderes que, sin embargo, no han podido alcanzar el nivel que se desea: la capacidad de comunicarse con la computadora en un lenguaje más cotidiano y no a través de códigos o lenguajes de control especializados.

Japón lanzó en 1983 el llamado "programa de la quinta generación de computadoras", con los objetivos explícitos de producir máquinas con innovaciones reales en los criterios mencionados. Y en los Estados Unidos ya está en actividad un programa en desarrollo que persigue objetivos semejantes, que pueden resumirse de la siguiente manera:

Se desarrollan las microcomputadoras, o sea, computadoras personales o PC.

Se desarrollan las supercomputadoras.

Inteligencia artíficial:

La inteligencia artificial es el campo de estudio que trata de aplicar los procesos del pensamiento humano usados en la solución de problemas a la computadora.

TIPOS DE MICROPROCESADORES

En la columna del número de transistores, los datos entre paréntesis incluyen a la caché L2 integrada. En la columna del rendimiento, el factor multiplicador es una estimación del autor basado en la frecuencia inicial de cada modelo, mientras que los datos entre paréntesis proceden de Intel, siendo Dhrystone MIPS para el modelo a la frecuencia que se indica. Aunque los MIPS apenas se utilizan, son la única medida de rendimiento que abarca el extenso marco temporal considerado.13 Durante la década de 1980, las dos compañías fabricantes de microprocesadores que mayor atención prestaron al sector de la informática doméstica, fueron Intel y Motorola. El abanderado de Intel durante esta década fue la familia 80x86, de la que se sucedieron del 8086: el 80286, el 80386 y el 80486. Motorola, por su parte, fue replicando a las novedades de Intel con modelos de su familia 68000: el 68020, el 68030 y el 68040. Debido a que los modelos de Intel son los más extendidos y por haber tenido una mayor continuidad en el tiempo, se puede realizar la siguiente reseña histórica.

Primera generación (1978-1982). A mediados de 1978 Intel lanza al mercado su primer procesador el 8086. Esta primera generación se caracteriza por la potencia de cálculo, las mejoras en la integración de circuitos permiten que el diseñador no encuentre las limitaciones tan fuertes que condicionaron el diseño del 4004 y el 8008, lo que posibilita la adopción de un ancho de 16 bits en la unidades de procesamiento y una complejidad inusual en las ALU, que ahora permiten instrucciones máquina para efectuar el producto y la división de números enteros. El 68000, lanzado al mercado por Motorola a finales de 1979, era un diseño microprogramado de 16 bits que rompió con la tendencia de Unidad de Control cableada que imperaba en aquella época. Su éxito comercial fue indudable, siendo adoptado no sólo por el Macintosh de Apple, sino también por las estaciones de trabajo de Sun y Hewlett-Packard hasta que éstos deciden crear sus propios procesadores RISC.

Segunda generación (1982-1985). Para estos años la capa de software comienza a madurar y demanda un espacio de direcciones mayor. La respuesta de hardware es, por un lado, ensanchar el bus de direcciones rebasando ya la frontera del Megabyte direccionable y por el otro, habilitar el concepto de memoria virtual que permite al procesador ejecutar programas mayores que es espacio físico de memoria disponible, siempre que las líneas del bus de direcciones permitan direccionarlo. Por lo que al final de esta época se alcanza el rango del Gigabyte direccionable, tanto en los modelos de Intel como en los de Motorola.

Tercera generación (1985-1989). Es entre estos años en que la memoria virtual supone tener que realizar una traducción de dirección virtual a física por cada acceso a memoria realizado, tarea de la que se encarga la MMU (Memory Management Unit). Intel retoma el diseño dual que había empleado con el tándem 8086/8088, desarrollando una versión recortada de su procesador 80386 a la que le coloca el sufijo SX. Esta idea se consagra en la sexta generación con los modelos Celeron, extendiéndose incluso a una tercera gama, más alta, con los modelos Xeon.

Cuarta generación (1989-1993). La potencia de cálculo vuelve a centrar la atención de los diseñadores de microprocesadores, y si en la primera generación es la computación de números enteros la protagonista ahora es la computación de números reales o de punto flotante. El microprocesador comienza a mostrar dependencia de su coprocesador matemático o FPU (Floating-Point Unit), la unidad funcional que realiza estas operaciones. Se decide así introducir ésta dentro del procesador para ganar velocidad y reducir el precio del conjunto. Desde este momento, el concepto del microprocesador cambia y presupone ya la existencia de esta unidad funcional como un elemento más. Los dos exponentes más importantes de esta generación son el 80486 y el 68040. Lanzados al mercado en 1989, disponen de FPU propia, que segmentan además en cinco y seis etapas. Este diseño se quedará muy corto conforme se vayan incorporando operaciones de mayor complejidad en generaciones posteriores.

Quinta generación (1993-1997). La frecuencia del microprocesador se desliga de la asociada al resto de la circuitería, provocando la aparición de un multiplicador de reloj que mide este desfase en velocidad y que pronto alcanza un valor superior a tres. Las mejoras en la tecnología de integración, que físicamente se han aprovechado para subir la frecuencia, permiten también contar con un par de millones de transistores más, que se van a emplear preferentemente en dotar al microprocesador de un agresivo paralelismo a nivel de instrucción, en el que se destacan una segmentación en 5 o más etapas. Con esas premisas, surge el Pentium, un procesador al que la historia le va a hacer un inmenso favor: tiene todo el mercado para él, y a pesar de ser una arquitectura terminal para Intel, será recordado por la firma como su éxito comercial más contundente La intención de AMD era lanzar el K5 para competir con el Pentium en esta generación, pero el retraso en su lanzamiento le obligó a asumir el rol de operador desde el primer momento.

Sexta generación (1997-2000).La idea en esos años consiste en dotar al microprocesador para PC de un carácter multiprocesador, incorporándole la circuitería necesaria para sincronizarse y colaborar con otros microprocesadores. En términos de rendimiento, esto queda un peldaño más arriba que el paralelismo interno a nivel de instrucción de la generación anterior, aunque uno más abajo que un multiprocesador puro, dado que se comparten todos los componentes de la placa base (buses, memoria principal y periféricos). Para este concepto se acuña la terminología multiprocesamiento simétrico o SMP (Sysmetric Mltiprocessing).

CARACTERÍSTICAS A TENER EN CUENTA EN UN PROCESADOR

1.- Velocidad bruta del procesador se mide en Ghz.

2.- Bits con los que trabaja, ya sea de 32 bits a 64 bits.

3.- Ancho de banda del bus de datos o FSB, existen varios tipos: 533Mhz, 800Mhz, 1000Mhz, 1066Mhz.

4.- Controlador de memoria: Los procesadores de marca INTEL no lo llevan integrado, mientras que los procesadores de marca AMD sí lo tienen integrado.

5.- Latencias: Es el tiempo de respuesta de la memoria, es menor en un AMD, por más que éste no use memorias tan rápidas.

6.- Memorias que requiere para funcionar: Un procesador como un Opteron de la empresa AMD tiene requerimientos muy estrictos, pero un Athlon64 no. Lo mismo del lado de Intel, siempre que sea necesario comprar un procesador es recomendable que se verifique esta información, para de esta manera poder comprar la tarjeta madre correcta, así como la memoria correcta.

1.7 CÓDIGOS DE TEXTO

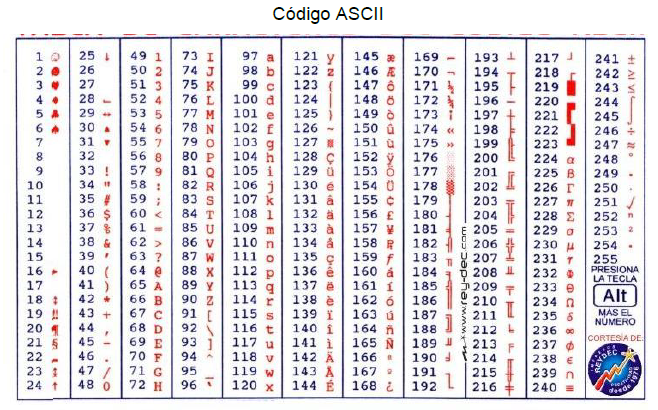

Al principio de la historia de la computación, los programadores se dieron cuenta de que necesitaban un código estándar, un sistema en el que todos pudieran estar de acuerdo con respecto a qué números representarían las letras del alfabeto, los signos de puntuación y otros símbolos. EBCDIC, ASCII y Unicode son tres de los sistemas más populares que fueron inventados.

EBCDIC. El sistema BCD (Código Decimal Binario: Binary Coded Decimal), definido por IBM, para una de sus primeras computadoras fue uno de los primeros sistemas completos para representar símbolos con bits. Los códigos BCD constan de códigos de seis bits, los cuales permiten un máximo de 64 símbolos posibles. Las computadoras BCD sólo podían trabajar con letras mayúsculas y con muy pocos otros símbolos. Por estas situaciones este sistema tuvo una vida corta.

La necesidad de representar más caracteres condujo a la IBM a desarrollar el sistema EBCDIC; el cual se pronuncia “EB-si-dic”, significa Código de Intercambio de Decimales Codificados en Binarios Extendidos (Extented Binary Coded Decimal Interchange Code).

El código EBCDIC es un código de ocho bits que define 256 símbolos. EBCDIC todavía se emplea en mainframes y sistema de rango medio de IBM, pero rara vez se encuentra en computadoras personales. Para cuando se estaban desarrollando las computadoras pequeñas, el Instituto Nacional Estadounidense de Normas (American Nacional Standars Institute:ANSI) había entrado en acción para definir normas para computadoras.

Código EBCDIC

ASCII. La solución de ANSI para representar símbolos con bits de datos fue el juego de caracteres ASCII. ASCII significa Código Estándar Estadounidense para el Intercambio de Información (American Standard Code for Information Interchange). Actualmente, el juego de caracteres ASCII es el más común. Los caracteres del 0 al 31 son caracteres de control; del 32 al 64 son caracteres especiales y números; del 65 al 96 son letras mayúsculas y unos cuantos símbolos; del 97 al 127, son letras minúsculas, y unos pocos símbolos comunes. Ya que el ASCII, un código de siete bits, especifica caracteres sólo hasta 127, hay muchas variaciones que especifican diferentes juegos de caracteres para los códigos del 128 al 255. La norma ISO (Organización Internacional de Normas: International Standards Organization) expandió el juego de caracteres ASCII para ofrecer diferentes juegos de caracteres para diferentes grupos de idiomas. ISO 8859-1, por ejemplo, cubre los idiomas de Europa occidental. Sin embargo, hay muchos otros juegos de caracteres para otros idiomas que usan un alfabeto diferente.

Unicode.Una norma para representación de datos que está en evolución, llamada Norma de Código Único para Caracteres Mundiales (Unicode

30

WorldWide Character Set), proporciona dos bytes, 16 bits, para representar cada símbolo. Con dos bytes, un carácter Unicode podría ser cualquiera de más de 65536 caracteres o símbolos diferentes, suficiente para cada carácter y símbolo en el mundo, incluyendo los vastos juegos de caracteres chinos, coreanos y japoneses y aquellos que se encuentran en textos clásicos e históricos conocidos. Si un juego de caracteres único estuviera disponible para cubrir todos los idiomas en el mundo entero, los programas y datos de computadora serían intercambiables. Debido a que esto es ciertamente una meta que vale la pena, posiblemente un día se dé el esfuerzo conjunto para reemplazar ASCII por Unicode. Muchos editores de software, incluyendo Microsoft , Nets cape y Accent, animan a sus desarrolladores a usar Unicode en sus programas.

ACTIVIDADES

ACTIVIDAD N°1 (MAPAS CONCEPTUAL)

entrar a http://www.spicynodes.org/ y realizar los siguientes mapas conceptuales

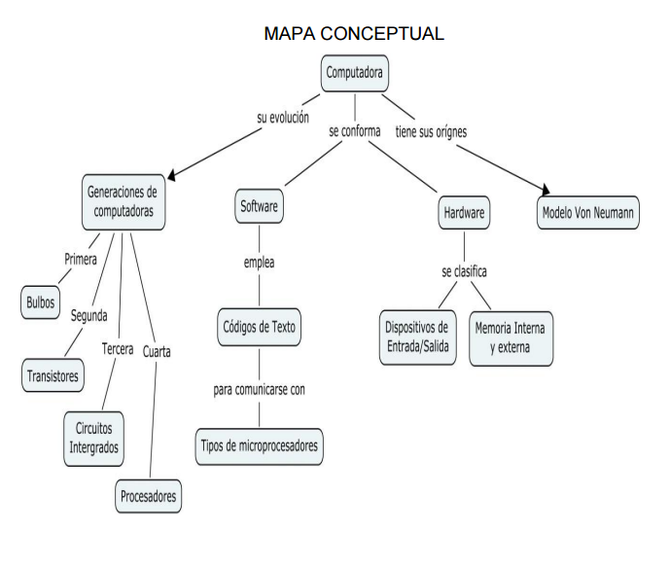

1. Realizar un mapa conceptual donde se ilustre el concepto de arquitectura de computadoras. Especificar la bibliografía consultada. Considerar ortografía, limpieza y puntualidad.

VER EJEMPLO

2. Realizar un mapa conceptual con respecto al concepto de computadora. Especificar bibliografía consultada. Considerar ortografía, limpieza y puntualidad.

VER EJEMPLO

3. Realizar un MAPA CONCEPTUAL de los elementos que integran una computadora: dispositivos de entrada, salida, y unidades de almacenamiento incluyendo las memorias.

4. Realizar un cuadro sinóptico donde se expongan las características más relevantes de cada una de las generaciones de computadoras

ACTIVIDAD N° 2 (SINTESIS MICROPOCESADORES)

Realizar una síntesis de los tipos de microprocesadores. Especificar bibliografía consultada. Considerar ortografía, limpieza y puntualidad.

EVALUACIONES

UNIDAD N° 2: UNIDAD CENTRAL DE PROCESAMIENTO

INTRODUCCIÓN

La computadora se encuentra conformada por software y hardware, el primero se define como el conjunto de programas de cómputo que permiten su funcionamiento; el segundo representa la colección de componentes físicos que conforman el equipo de cómputo, estos en conjunto conforman a la computadora. Pero internamente aloja un elemento importante: la unidad central de procesamiento (UCP), que a su vez para procesar la información emplea la unidad de control, unidad de aritmético-lógica y como elemento de almacén de datos, la memoria.

2.1 PLACA PRINCIPAL

Una computadora personal típica, en su hardware, está conformada por una placa de circuito impresa denominada placa madre o en otras bibliografías nombrada tarjeta madre (en inglés motherboard). La placa base es el hardware que alberga al chip del procesador, la memoria principal y algunas interfaces de E/S. Asimismo tiene conectores adicionales en los que se pueden enchufar interfaces adicionales.

El bus del procesador es definido por las señales propias del chip del procesador. Los dispositivos que requieran alta velocidad de conexión con el procesador, como la memoria principal, pueden conectarse directamente a este bus. La tarjeta madre proporciona generalmente otro bus al que se pueden interconectar otros dispositivos. Los dos buses son interconectados por un circuito, que se denominará puente, que traslada desde un bus a otro las señales y protocolos. Los dispositivos conectados al bus de expansión, muestran al procesador como si estuvieran conectados directamente al propio bus del procesador.

2.2 MICROPROCESADOR O UNIDAD CENTRAL DEL PROCESO (CPU)

La CPU (Unidad Central de Procesamiento) es el lugar en donde se manipulan los datos, se conoce como el cerebro de la computadora, la CPU contiene un pequeño chip llamado microprocesador. Cada CPU está formada por al menos de dos partes básicas: la unidad de control y la unidad lógica-aritmética

2.2.1 Unidad de control

La unidad de control es el centro lógico de la computadora ya que los recursos de una computadora son administrados en la unidad de control, es esta unidad la que se encarga de dirigir el flujo de datos.31

Las instrucciones de la CPU se encuentran incorporadas en la unidad de control, estas instrucciones o conjunto de instrucciones enumeran todas las operaciones que una CPU puede realizar. Cada instrucción es expresada en microcódigo.

Antes de que un programa sea ejecutado, cada comando debe desglosarse en instrucciones que correspondan a las que están en las instrucciones de la CPU. Al momento de ejecutar el programa, la CPU lleva a cabo las instrucciones en orden convirtiéndolas en microcódigo. A pesar de la complejidad que resulta del proceso, la computadora puede realizar este proceso a una velocidad increíble.

Cuando una CPU es desarrollada, el conjunto de instrucciones tiene los mismos comandos que su predecesora, aparte de incluirle algunos nuevos. Esto permite que el software escrito para una CPU trabaje con computadoras con procesadores más recientes, esta estrategia es llamada Compatibilidad ascendente. Esta característica permite ahorrar a los consumidores comprar un sistema nuevo cada vez que una parte del sistema es actualizada.

Se le conoce compatibilidad decreciente o inversa, cuando un dispositivo del hardware o pieza del software puede interactuar con el mismo equipo y software que su predecesor.

2.2.2 Unidad lógica-aritmética

Los datos almacenados en una computadora son de tipo numérico, es por ello que gran parte del procesamiento involucra la comparación de números o la realización de operaciones matemáticas. Dentro de la unidad lógica aritmética de la computadora se realizan sólo dos tipos de operaciones: operaciones aritméticas y operaciones lógicas

En el cuadro siguiente se muestra las operaciones realizadas por la unidad lógica aritmética

2.3 REGISTROS

Antes de escribir un programa o de investigar una instrucción, es necesario conocer la configuración interna del microprocesador. A continuación se analiza la arquitectura interna de los microprocesadores del 8086 al Pentium 4, la cual está visible para los programas.

2.3.1 De propósito general

Algunos registros son de propósito general (o registros multipropósito), mientras que otros tienen propósitos especiales. A continuación se describen los registros multipropósito.

2.3.3 De instrucciones

EIP (apuntador de instrucciones). EIP direcciona la siguiente instrucción en una sección de memoria definida como segmento de código. Este registro es IP (16 bits) cuando el microprocesador opera en modo real y EIP (32 bits) cuando el 80386 y superiores operan en modo protegido. Los procesadores 8086, 8088 y 80286 no contienen un registro EIP, por lo que sólo el 80286 y superiores operan en modo protegido. El apuntador de instrucciones, que apunta a la siguiente instrucción en un programa, se utiliza por el microprocesador para encontrar la siguiente instrucción secuencial en un programa ubicado dentro del segmento de código. El apuntador de instrucciones puede modificarse mediante un salto (jump) o una instrucción de llamada

2.3. BUS

El término Bus se refiere a las rutas entre los componentes de una computadora. En una computadora existen dos buses principales: El Bus de datos y el Bus de direcciones, el más conocido es el Bus de datos.

2.4.1 Bus de datos

El Bus de datos es una ruta que conecta la CPU, la memoria y otros dispositivos de hardware en la tarjeta madre.

El bus de datos es un grupo de cables paralelos, el número de cables en el bus afecta la velocidad a la que los datos pueden viajar entre los dispositivos del hardware. Los buses de datos pueden ser de 16 y 32 bits y pueden transferir 2 y 4 bytes respectivamente.

El bus AT es conocido como bus de Arquitectura Estándar de la Industria (Industry Estándar Architecture: ISA), el cual tenía un ancho de 16 bits, todavía es usado por dispositivos de PC que no requieren de un bus de más de 16 bits.

Para el bus de 32 bits fue necesaria una nueva norma, el primer competidor fue el bus de Arquitectura de Microcanal (Micro Channel Architecture: MCA), de IBM. Después vino el bus de Arquitectura Industrial Extendida Estandar (Extended Industry Standard Architecture: EISA). El ganador fue el bus de Interconexión de Componentes Periféricos (Peripheral Component Interconnect: PCI). Intel diseñó el bus PCI de manera específica para facilitar la integración de nuevos tipos de datos como sonido, video y gráficos

2.4.2 Bus de direcciones

El bus de direcciones al igual que el bus de datos, es un juego de cables que conecta la CPU a la RAM y lleva direcciones de memoria. Cada byte en la RAM se asocia con un número, el cual es la dirección de memoria.

La importancia del bus de direcciones radica en los cables, ya que en este determina la cantidad máxima de direcciones de memoria. En la actualidad las CPU tienen buses de 32 bits que pueden direccionar 4 GB de RAM, es decir, más de 4 mil millones de bytes.

Una de las dificultades en la evolución de las PC fue que el sistema operativo DOS sólo direccionaba 1 MB de RAM, por lo que cuando las PC comenzaron a contener más RAM, tuvo que diseñarse software especial para direccionarla. Los programadores propusieron dos dispositivos, llamados memoria expandida y memoria extendida, la que aun existe en el sistema operativo es la memoria extendida con propósitos de compatibilidad decreciente

2.5 MEMORIA PRINCIPAL

A continuación se expone terminología básica referente al concepto de memoria.

Celda de memoria. Se define como un dispositivo o circuito eléctrico usando para almacenar un solo bit (0 o 1). Ejemplos de éstos son: flip-flop, un capacitor cargado y un solo punto en una cinta magnética o en un disco.

Palabra de memoria. Un grupo de bits (celdas) en una memoria que representa datos de algún tipo.

Byte. Término especial empleado para definir a un grupo de 8 bits. Los tamaños de palabra se pueden expresar en bytes o en bits.

Capacidad. Es una forma de especificar cuántos bits se pueden almacenar en un dispositivo de memoria específico, o sistema de memoria completo.

Operación general de la memoria. A pesar de que cada tipo de memoria es diferente, en su operación interna, ciertos principios básicos de operación son los mismos para todos los sistemas de memoria.

Cada sistema de memoria requiere distintos tipos de líneas de entrada y salida para realizar las siguientes funciones:

1) Seleccionar la dirección en memoria a la que se tiene acceso para una operación de lectura o escritura.

2) Seleccionar una operación de lectura o escritura para su ejecución.

3) Suministrar los datos de entrada que se almacenarán en la memoria durante una operación de escritura.

4) Retener los datos de salida que provienen de la memoria durante una operación de lectura.

5) Habilitar (o deshabilitar) la memoria de modo que responda (o no) a las entradas de dirección y al comando de lectura-escritura.

La unidad central de procesamiento contiene instrucciones básicas necesarias para operar la computadora, pero no tiene la capacidad para almacenar programas o conjunto grandes de datos en forma permanente.39 La CPU contiene registros, los cuales son pequeñas áreas que pueden conservar sólo unos cuantos bytes a la vez. La CPU demanda tener millones de bytes de espacio donde pueda guardar los programas y datos que se están manipulando mientras se encuentran en uso. A esta área se le conoce como memoria.

Existen dos tipos de memoria incorporados: permanente conocida también como volátil y la no permanente conocida como no volátil.

ROM. Los chips no volátiles conservan siempre los mismos datos, es decir, éstos no pueden cambiarse. Los datos en estos chips sólo pueden ser leídos y usados, no pueden ser cambiados, por lo que se llama memoria de sólo lectura (read-only memory: ROM). La tarea principal de esta memoria, se basa en que le da las primeras instrucciones a la computadora cuando se conecta a la energía por primera vez.

RAM. Comúnmente llamada memoria de acceso aleatorio (random accesss memory: RAM). El objetivo de esta memoria es conservar datos y programas mientras están en uso. La RAM optimiza el funcionamiento de la computadora debido a que no busca en toda la memoria cada vez que necesita encontrar datos, ya que la CPU almacena y recupera cada pieza de datos usando una dirección de memoria. Dicha dirección es un número que indica la ubicación en los chips de memoria, éstas comienzan con cero y continúan en forma ascendente hasta uno menos que el número de bytes de memoria en la computadora

2.6 FUENTE DE ALIMENTACIÓN ELÉCTRICA

En toda computadora existe un reloj del sistema, este reloj es accionado por un cristal de cuarzo que al momento de aplicarle electricidad las moléculas en el cristal vibran muchas veces cada segundo. Estas vibraciones son usadas por la computadora para medir sus operaciones de procesamiento.41

Al paso de los años las velocidades de los relojes se ha incrementado constantemente. La primera PC operaba a 4.77 megaHertz (millones de ciclos por segundo). Un ciclo de reloj es el tiempo que le lleva un transistor en apagarse y encenderse

La fuente de alimentación eléctrica de una computadora proporciona a ésta la energía necesaria a los circuitos de la unidad central de proceso, y demás elementos hardware que la conforman.

Esta fuente de alimentación tiene como objetivo reducir las variaciones de voltaje existentes en la toma de corriente. Internamente se encuentra provisto de un ventilador que disipa el calor desprendido por el propio bloque y en términos generales también por la computadora.

En la entrada de esta fuente se encuentra un cable que se conecta a la red eléctrica; en la salida varios cables en paralelo que se conectan con la tarjeta madre, así mismo sirven como fuente de alimentación de las unidades de disco y demás dispositivos.

Esta alimentación provee energía a la salida garantizando el funcionamiento adecuado de la computadora. La fuente estabiliza las tensiones presentadas. El fabricante especifica el rango de variación que se tolera. Las tensiones normalizadas son de +-12V y +-5V.

ACTIVIDADES

REALIZAR UN DOCUMENTO COOPERATIVO SOBRE LA UNIDAD ADEMAS DEBEN ESPECIFICAR LO SIGUIENTE:

- Realizar un resumen de las tarjeta madre más comunes en el mercado, señalando características, rendimiento y precios

- tipos de registros de la computadora

- tipos de buses

- tipos de memoria RAM actuales, además de investigar precios

- resumen de Fuentes de alimentación eléctrica.

OFIMATICA CENSA

OFIMATICA CENSA

tabla de microprocesadores (miércoles, 17 febrero 2016 16:39)

tipos de microprocesadores